Una guía rápida para escribir un archivo Robots.txt

¿Cómo se consulta un libro de texto enorme? Examinando el índice. Bueno: hay un elemento que es el verdadero resumen de tu sitio web…

La única forma de ponerse en contacto con la araña del motor de búsqueda, o el rastreador, es a través de un archivo llamado robots.txt. O mejor. Cuando envía su propuesta de sitio web a Google, se enfrenta a una cantidad de información simplemente colosal.

¿Cómo consulta un libro de texto tan grande que siente que nunca encontrará todo lo que necesita? tu consulta la pista. Bueno: el archivo robots.txt es el índice de tu sitio web.

Este es un documento fácil de completar que le dice al rastreador del motor de búsqueda qué buscar. En resumen: lo ayudarás a comprender de qué está hecho tu sitio, para que el algoritmo pueda darte una clasificación adecuada al trabajo que has realizado.

¿Alguien puede escribir un archivo robots.txt?

La respuesta corta es sí. La respuesta honesta es no. Aunque la gramática de un archivo robots.txt es extremadamente simple, y su composición consta de unas pocas líneas, es mejor confiar en el cuidado de un webmaster experto que sepa dónde poner las manos. Después de todo, un pequeño error es suficiente para comprometer el posicionamiento de su sitio web y, por lo tanto, detener todas las operaciones de SEO incluso antes de comenzar.

Antes de empezar, sepa una cosa: cualquiera puede consultar el archivo robots.txt de cualquier sitio escribiendo /robots.txt después del dominio. ¡Incluso puedes consultar las de Google!

Puede escribir dicho archivo sin descargar un software especial. De hecho, es suficiente usar tu bloc de notas y guardar, adivina qué, en formato .txt.

Escribamos juntos un archivo robots.txt: el encabezado

Empecemos por el principio, como siempre es lógico hacerlo. La apertura del archivo, o más bien el encabezado, está enteramente dedicado al nombre de la araña, precedido por una pequeña redacción que es siempre la misma. Supongamos que desea llamar la atención de Google. Así que la primera línea será:

Usuario-agente: Googlebot

Esta cadena muy corta le dice a Google que todo lo que sigue seguramente será de su interés. En caso de que quieras que todos los rastreadores que leen este tipo de archivos puedan consultar el documento, sustituye Googlebot por un simple *, un asterisco.

Ahora que ha indicado qué araña, es decir, QUIÉN, deberá indicar también QUÉ tendrá que leer.

Cada línea de código, por definición, corresponde a una acción de la máquina. No hace falta decir que cada comando en el archivo robots.txt corresponde a lo que la máquina no debe hacer. Y esta es la clave que te permite escribir uno realmente efectivo. Estamos hablando del comando DISALLOW.

¿Qué es el comando DISALLOW?

Il rechazar comando permite razonar por exclusión. En otras palabras, cuando se dice que primero es decir lo que no se debe hacer, bueno, estás razonando por exclusión. Además del rechazo, también existe el permiso, que es la excepción al bloqueo.

Si desea escribir un buen archivo de robots, tendrá que pensar al revés, por lo que tendrá que decirle a Google lo que no debe leer. Si tú escribes:

Disallow:

La araña leerá todo su sitio, sin frenos.

Si después de "Rechazar:" inserta una barra inclinada (por lo tanto, Rechazar: /), el sitio no se ingresará en los motores de búsqueda, punto final.

No permitir: /directorios/

Reemplace el directorio de palabras con la carpeta que desea que se le niegue desde la vista de araña. Puede hacer lo mismo con un archivo específico.

No permitir: /miarchivo.html

Atención a puntuación y letras, mayúsculas o minúsculas. Este tipo de archivo tiene en alta estima este tipo de "pequeñeces", pero marcan una gran diferencia.

¿Por qué impediría que Google leyera gran parte de su sitio? Cuando escribes un archivo de este tipo, es importante entender qué archivos no deben aparecer en el buscador, pero sin abusar de ellos. Sin embargo, sepa que cualquiera que sepa la dirección exacta de ese archivo en particular podrá acceder a él en cualquier caso.

¿Qué es el comando PERMITIR?

En el archivo puede agregar una excepción con el comando PERMITIR. La gramática es idéntica, pero creará algunas excepciones a DISALLOW que permitirán abrir interesantes márgenes de exploración para la araña.

Un pequeño archivo de muestra:

Usuario-agente: Googlebot

No permitir: /imágenes/

Permitir: /images/vacaciones.jpg

Básicamente, le dijimos al robot de Google que no considerara la carpeta de imágenes, a excepción de una foto en particular dentro de ella, a saber, la de las vacaciones.

Y eso, chicos, es todo. Escribimos nuestro primer archivo robots.txt. Claro, lo que vamos a hacer para el sitio real puede ser un poco diferente, pero no mucho. En caso de duda, asesórese siempre con un webmaster especializado. Le recomendamos que intente escribirlo usted mismo, en primer lugar, y enviárselo para que lo revise, para dominar los rudimentos y comprender mejor cómo funciona su sitio.

¿Cuál es la correlación entre robots.txt y sitemaps?

El mapa del sitio es un archivo generado por complementos especiales que contiene todos los enlaces del sitio. Cuando la araña ingresa al sitio, primero lee los robots y luego rastrea el sitio. Si durante el rastreo el robot encuentra la dirección del mapa del sitio, todo el proceso será mucho más fácil.

Agregue lo siguiente al código anterior:

mapa del sitio: http://www.ilnomedeltuositobellissimo.com/sitemap.xml

En conclusión

Todos los archivos de robots son iguales. Esto significa que un archivo de Robots escrito para Google también funcionará bien para Bing y sigue la misma gramática.

Un archivo robots.txt bien organizado le permite ahorrar tiempo de rastreo. No te desanimes: ¡este es el primer paso hacia el éxito!

También te puede interesar:

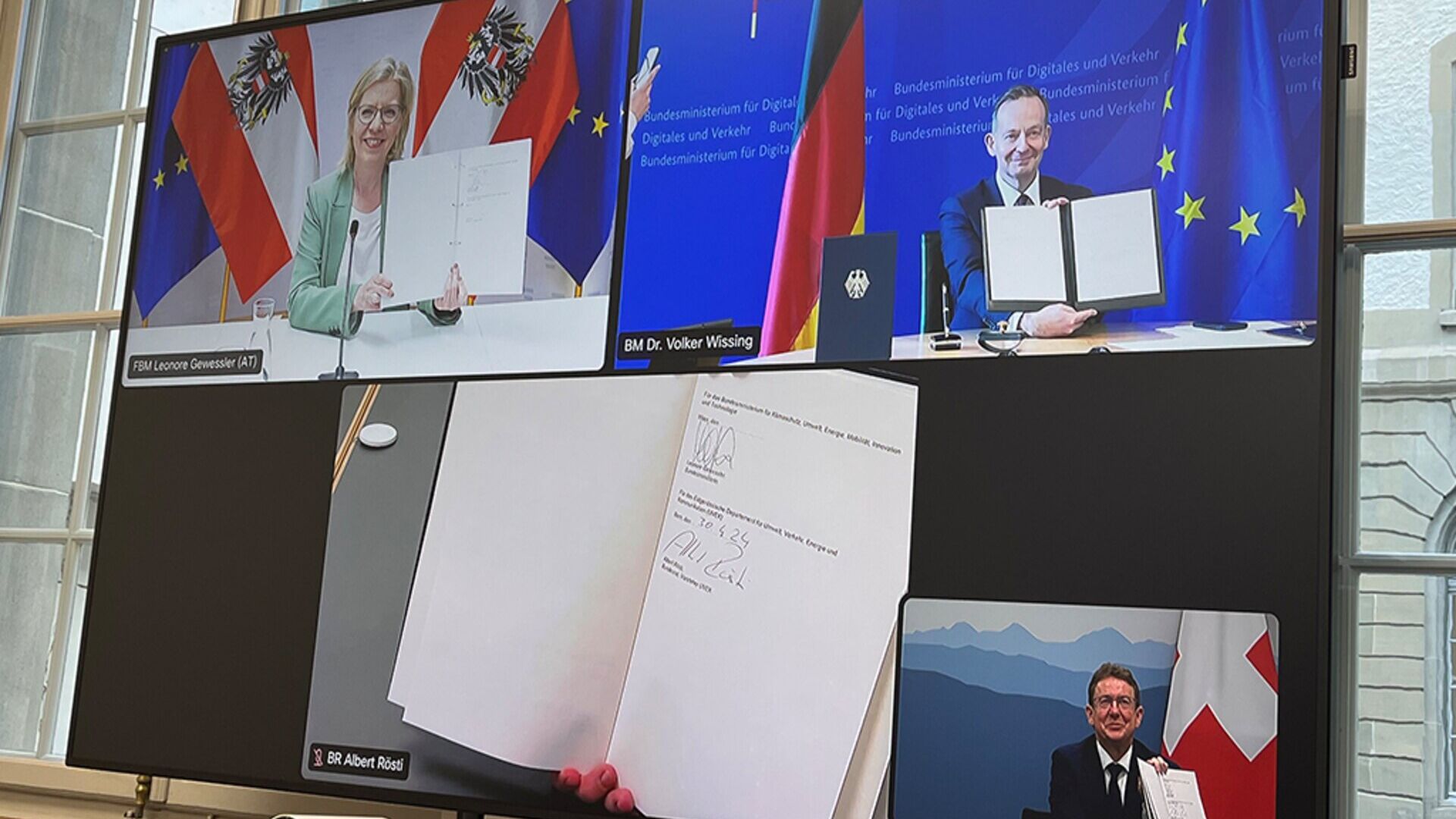

Austria, Alemania y Suiza por ferrocarriles de carga "más innovadores"

Ministros de DACH Leonore Gewessler, Volker Wissing y Albert Rösti: la introducción del emparejamiento automático digital es un elemento clave

por Redacción Innovando.NoticiasRedacción de Innovando.Noticias

¿Persuasión o manipulación? Génesis e impacto histórico de las relaciones públicas

Así las Relaciones Públicas, desde el diálogo sofista de la antigua Grecia hasta la actual era digital, siguen ofreciendo innovación continua

por Francesca CaónDirector General de Relaciones Públicas de CAON

Jóvenes y criptomonedas: cómo saber más sobre Bitcoin…

Introducir a los niños a las monedas digitales y Blockchain puede ser una tarea apasionante, dada su afinidad por la tecnología y la innovación.

“El paciente en el centro”: una gran esperanza y una reunión en el Senado

El tema de la importancia de la innovación en productos sanitarios para la sanidad europea será abordado el 15 de mayo en Roma por expertos y políticos

por Alberto NicoliniEditor de districtbiomedicale.it, BioMed News y Radio Pico